20 novembre 2012

par maryam khiali

1 Commentaire

Alors le big data c’est quoi ? C’est quand on est confronté à ces 4V :

- Volume de données très important (structurées ou non-structurées)

- Vitesse à laquelle les données sont générées ou sont à traiter : très rapidement ex : data de twitter ou facebook

- Variétés des données importantes

- Variabilités d’interprétation d’une même donnée en fonction du contexte

Pour répondre à ces problématiques, plusieurs choses sont à envisager :

- une bonne infrastructure

- une autre manière de stocker les données car les bases de données relationnelles arrivent à leur limite

- une autre manière d’interroger les données car le SQL arrive à sa limite

Dans ce post je vais vous exposer la réponse de Microsoft face au big data…Enfin de ce que j’en ai compris…

Coté Infrastructure :

Pour répondre à la sollicitation du big data Microsoft propose 2 architectures en fonction de la taille de votre futur DWH et de votre besoin de calcul :

Symetric multi-processing SMP : est une architecture qui consiste à multiplier les processeurs identiques au sein d’une même machine, de manière à augmenter la puissance de calcul, tout en conservant une unique mémoire. On prendra cette offre dans le cas suivant :

- Petit/moyen DWH

- limité

- traitements que l’on ne peut pas séparer

Massively Parallele Processing MPP va être conseillé pour du grid computing * (donc du calcul intensif). C’est une architecture qui consiste à multiplier le nombre de processeur ou d’ordinateur pour faire de la parallèlisations. Il y a un nœud de contrôle qui dispache ça sur n nœud de traitement et de stockage. On prendra cette offre dans le cas suivant :

- Gros DWH

- Besoin de Prédictif

- gros besoin de calculs

* Grid computing (HPC server Hight performance computing) est une architecture permettant de répartir des calculs sur une ferme de serveur pour des calculs intensifs. Cette ferme peut être mise dans le Cloud computing pour payer à la demande et pas les serveurs, etc.

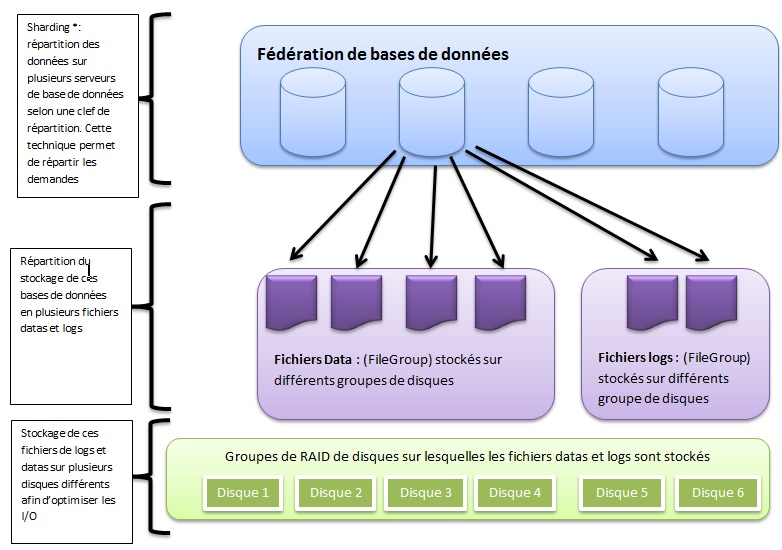

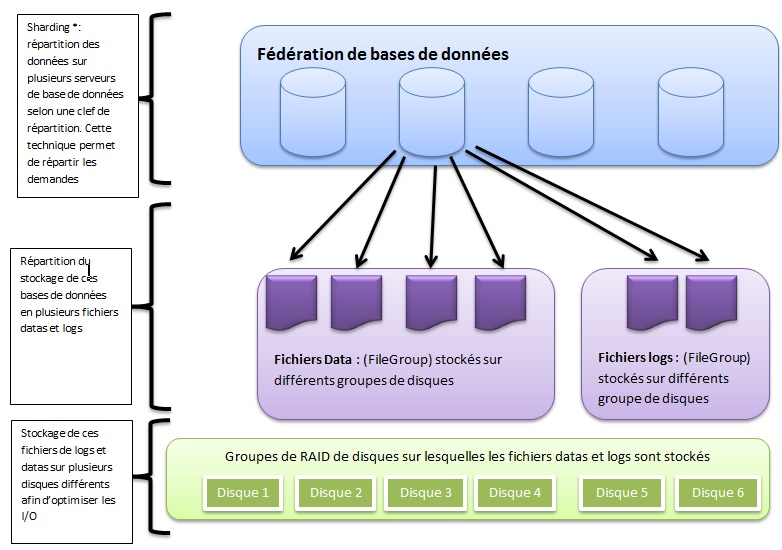

Exemple pour optimiser son mode de stockage pour toujours plus de de performance avec du MPP:

Microsoft propose 2 appliances :

- SQL Server 2008 Fast tracks : implémentation SMP de SQL server Enterprise 2008

- SQL server 2008R2 Parallel datawarehouse : implémentation MPP de SQL server Enterprise 2008

Une appliance est un serveur pré-calibré. Les composants sont utilisés au mieux. On arrive à prédire l’évolution de son système. (Ex : Bull qui fait livrer des serveurs avec ces appliances déjà tous configurés). Pour en savoir plus, voir cette vidéo

Coté type de stockage:

Microsoft en propose 2 types :

- Type blob storage : pour des données volumineuses non structurées ex : image, vidéos…

- Type table: clés valeurs partition et clé de ligne (Pour en savoir plus aller voir un de mes posts précédent)

Coté interrogation des données :

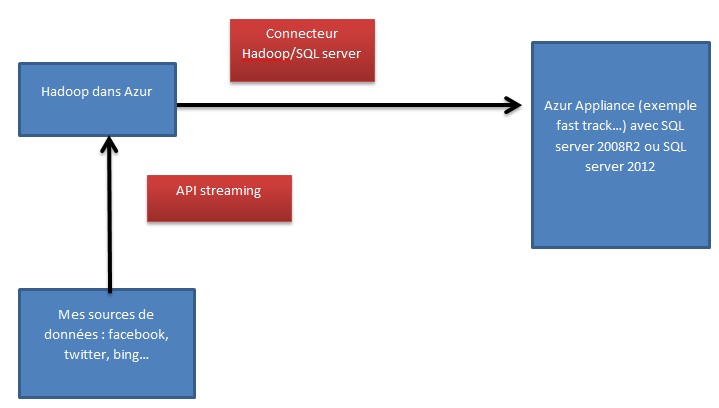

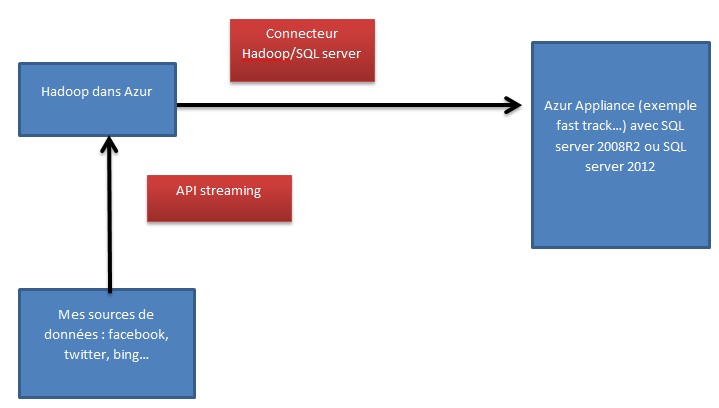

Microsoft a misé sur l’outil Hadoop. Dans le schéma suivant vous pouvez entrevoir le chemin des données :

Les données sources exemple facebook, twitter, bing… sont interrogées via Hadoop par les API streaming que ces éditeurs proposent.

Ensuite quand ces données seront stockées dans des bases de données sous format type table (clés/valeurs) ou type blog, le connecteur Hadoop/SQl server permettra d’aller requêter ces données selon 2 façons :

- Soit en requête via du Javascript ou du dotnet grâce au framework Daytona avec la méthode MAP/REDUCE

- Soit en utilisant l’option Hive table dans Hadoop qui permettra de construire des tables virtuelles pour ensuite les interroger avec un langage tel que Scoop ou encore Pig qui ressemble un peu plus à du SQL qui lui-même sera transformer en Javascript pour interroger la base de données clés/valeurs ou blob.

Si vous aussi, vous avez assisté à des conférences sur le big data, comment y faire face, ou si vous avez déjà participé à un projet big data n’hésitez pas à partager vos opinions

D’ailleurs ce post expose les solutions que propose Microsoft mais les solutions d’autres outils sont les bienvenus.