Il y a quelques jours, j’ai assisté à une conférence très intéressante, animée par Claranet.

Cette conférence montrait que Claranet vient de mettre en place grâce à son partenariat avec Nutanix une plateforme d’hébergement « new génération ». Cette plateforme permettra de répondre à toutes les problématiques futures du big data : voir l’article journal du net.

Afin d’illustrer l’utilité de ces plateformes, il nous a été présenté comment facebook gérait sa volumétrie de données.

Facebook utilise hadoop avec en système de stockage HDFS et en système de gestion de base de données Hbase.

Facebook a séparé en 3 sa gestion de données :

- OLTP : pour tout ce qui est online.

- ODS : pour toutes les métrics des serveurs

- Datawarehouse : les anciens, messages, documents (c’est la vie des données)

Avec Hbase, facebook gère des milliards de messages en tout genre par jour. Le challenge est de proposer un service haute disponibilité, performant, avec un système qui permet de retrouver les données facilement.

Voici des cas concrets d’utilisation de HBase :

Exemple 1: Pour monitorer leur serveur, facebook stock des metrics (nb noeud, CPU, RAM, I/O, flash memory, SSD…) dans leur ODS. Avec Hbase, ils ont des bonnes performances et un bonne interface graphique pour interpréter les données ( à travers des graphiques)

Exemple 2: Il l’utilise aussi pour analyser la popularité d’une URL : (nb clics, si les Flux de cette URL sont lus, si la page est lue, s’il partage ce lien, leur localisation…)

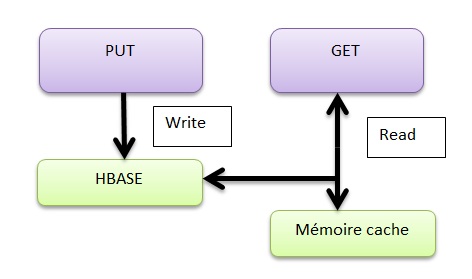

Exemple 3 : Géneric key value

Un autre utilité est de proposer un système de stockage uniforme : plus besoin de créer de MCD, le stockage clef/valeur permet aux applications de facebook de stocker leurs données de la même manière.

Ce genre d’accès est facile à monitorer

Exemple 4 : Graph Search Indexing

Pour le datawarehouse, voici un exemple de stockage.

rowKey : documentID (exemple une photo)

value : terms, données du document

Graph Search Indexing permet donc de faciliter la recherche de document à travers ce stockage clef/valeur.

Les principes prioritaires à retenir d’après facebook :

- la haute disponibilité est primordiale

- il faut liumiter l’intervention humaine

- être en update continue (opposition au système de version)

- prévoir les rack failures

-pourvoir monitorer ces serveurs à travers des metrics

- monitorer ces noeuds (en avoir de réserve en cas de pb, voir pourquoi un noeud se désactive automatiquement car il y a un problème, ajouter un noeud pour plus de monter en charge…)

Ces exemples illustrent un système de stockage souple qui répond à plusieurs problématiques.

Maintenant, Nutanix propose une architecture flexible (voir la video) en plus ce de genre de système de stockage. L’un des avantages au niveau de l’architecture proposée est qu’il n’y a plus besoin de SAN (très couteux).

L’alliance du système de stockage HDFS et de l’architecture que propose Nutanix garanties un projet dans le cloud, scalable et flexible.

J’espère avoir bien saisi les concepts évoqués dans cette conférence car ce n’était pas évident. En effet, il y a des concepts que je ne connaissais pas et la présentation était en full anglais.

N’hésitez pas à me faire vos retours.